Webalizer는 아파치 서버의 로그를 자세한 통계로 보여주는 서버관리자에게는 상당히 유용한

툴이다. 물론 Webalizer 말고 다른 로그분석툴이 많지만 일단 Webalizer가 가장많이 쓰이고

윈도우용으로 Cygwin으로 컴파일되어서 제공되기 때문에 설치도 비교적 간단한 편이다.

(설치방법은 http://xens.dnip.net/54 참고) 설치만 해놓고 그냥 보기만 해서는 잘이해가 되지

않을것이다. 그래서 내 블로그의 6월분 로그내용을 가지고 분석하는 방법을 알아보겠다.

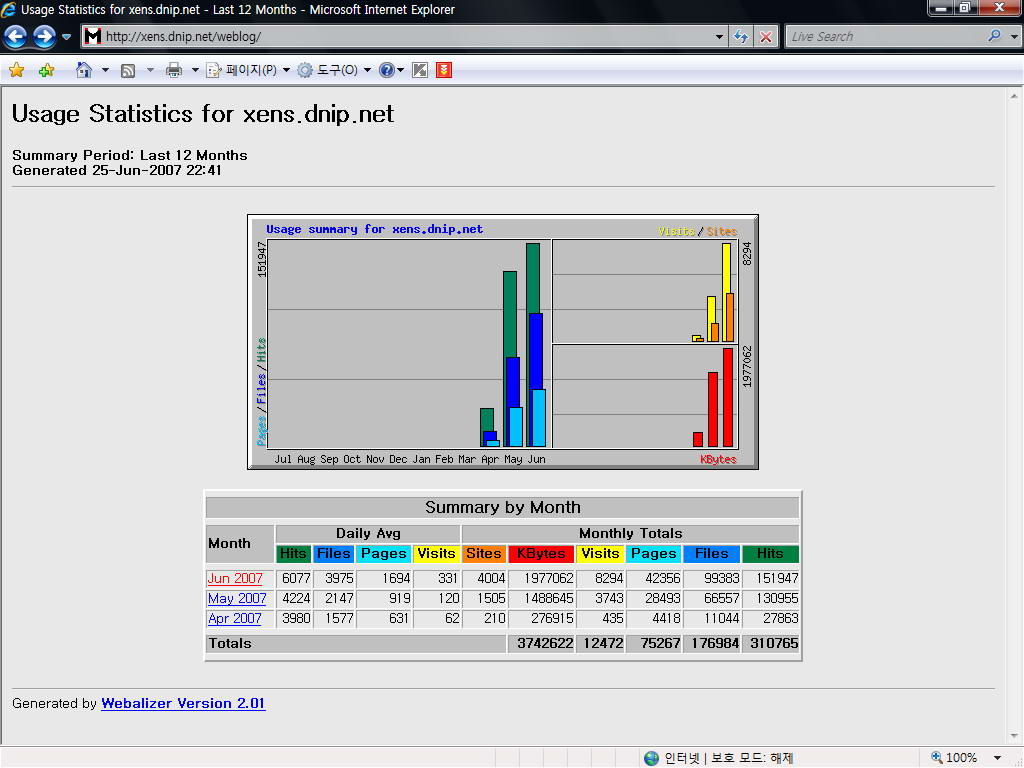

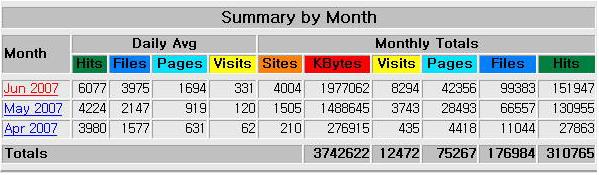

웹얼라이저를 실행하면 다음과 같이 접속 통계를 일단 간단히 볼수 있다. 항목별로 자세히 보자.

웹페이지까지 합해 4개의 Hits가 올라간다. 07년 06월 Daily Avg의 Hits를 보면 6077인데 이는

하루에 일평균 6076개의 이미지가 (한페이지라고만 가정했을때) 요구되었다고 보면 되겠다.

한페이지에 있던 이미지라고 가정했을때 이미지 3개가 하루동안 대략 2000명의 사용자에게

요구되었다고 해석하면 편하겠다.(블로그 특성상 여러페이지에서 클라이언트들의 요청이

있기때문에 쉽게 이렇게 가정한것이다.)

KBytes : 클라이언트들에게 전송된 웹페이지 정보량의 합계이다. 6월 25일까지 1,977,062Kbytes가

요청되었다.

Visits : 방문객들의 총합이다. 하루평균 331명이 들어온다고 나와있지만 검색엔진 로봇들도 포함

되었기 때문에 실제 방문객 수는 이것보다 적을것이다.

Pages : 방문객이 실제로 서버에 접속한 웹페이지의 합계이다. 만약 어떤 방문객이 내 블로그를

방문해서 각각 3개의 이미지가 있는 5개의 페이지를 봤다면 Hits는 (방문객1+이미지수3)*

웹페이지수5 로 계산이 되어 20이올라가게 된다. 그리고 방문객 1명이 와서 열람했으므로

당연히 visits는 1이 올라가고 Page를 5개를 봤으므로 Pages는 5개가 올라간다.

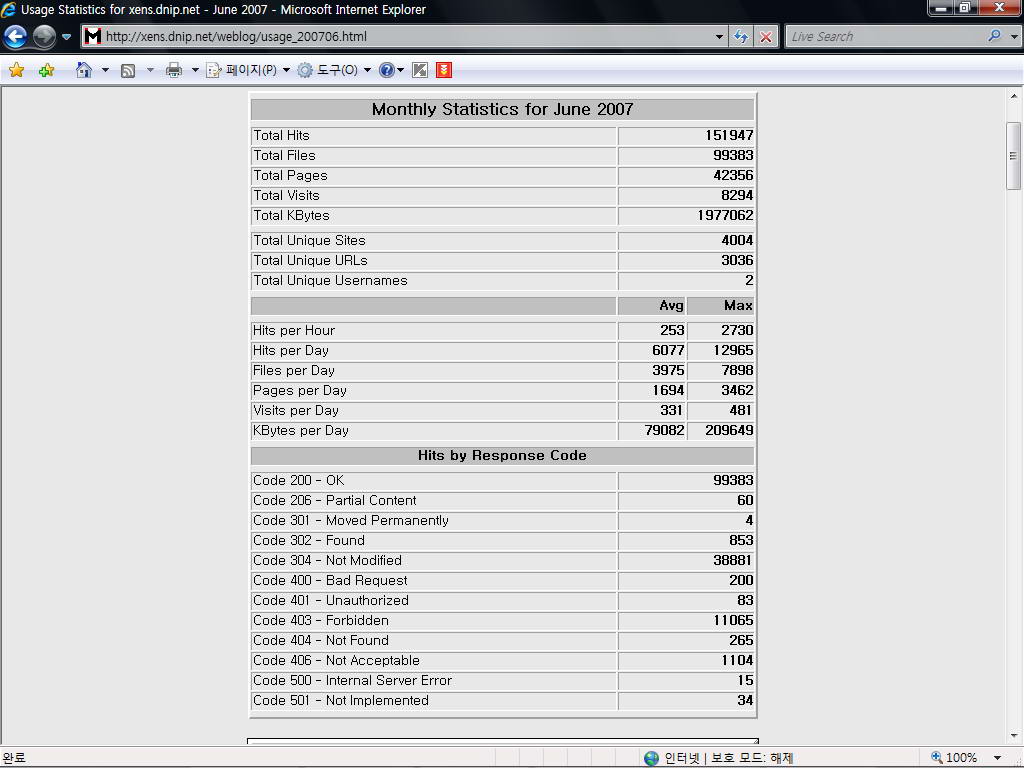

여기까지는 대략적으로 알아본것이고 이제 6월분의 자세한 웹로그 통계를 살펴보겠다.

어떻게 증가되는지 알아봤기 때문에 전체적인 내용을 판단하기에 쉬울것이다. 응답코드에 대한

히트수를 보면 대략 클라이언트들이 어느종류의 요청을 했는지 알수있다. 예를들어 이그림에서

404에러같은 경우 265 Hits가 발생했는데 총 265번의 없는페이지를 사용자가 접속하려 했다고

해석할수 있겠다. 이그림에서 보이는 히트수들은 내가 저질러 놓은것들이 상당히 많아서 별로

신뢰성이 없다.

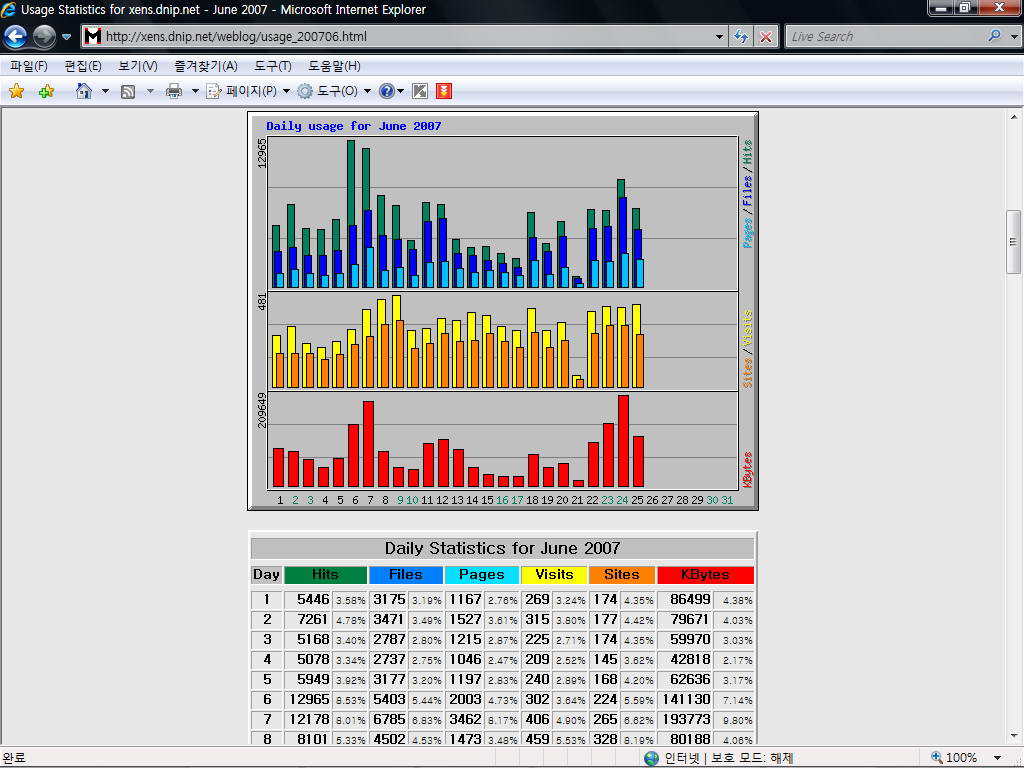

일별통계를 그래프와 함께 볼수 있다. 아래는 짤려있지만 6월 25일까지 집계되있고 그래프를 보면

일별로 어느날이 접속자수가 많은지 쉽게 알수있고 어느날에 Hits나 다운로드량이 많았는지도 알수

있다. 여기서는 6월 9일에 접속자가 가장 많았고 페이지 검색은 6일에 가장 많은것을 볼수있다. 다운

로드량은 24일에 가장 많은것을 볼 수 있다. 그래프 아래에서는 일별로 자세한 데이터가 집계되어

있는것을 볼수있다.

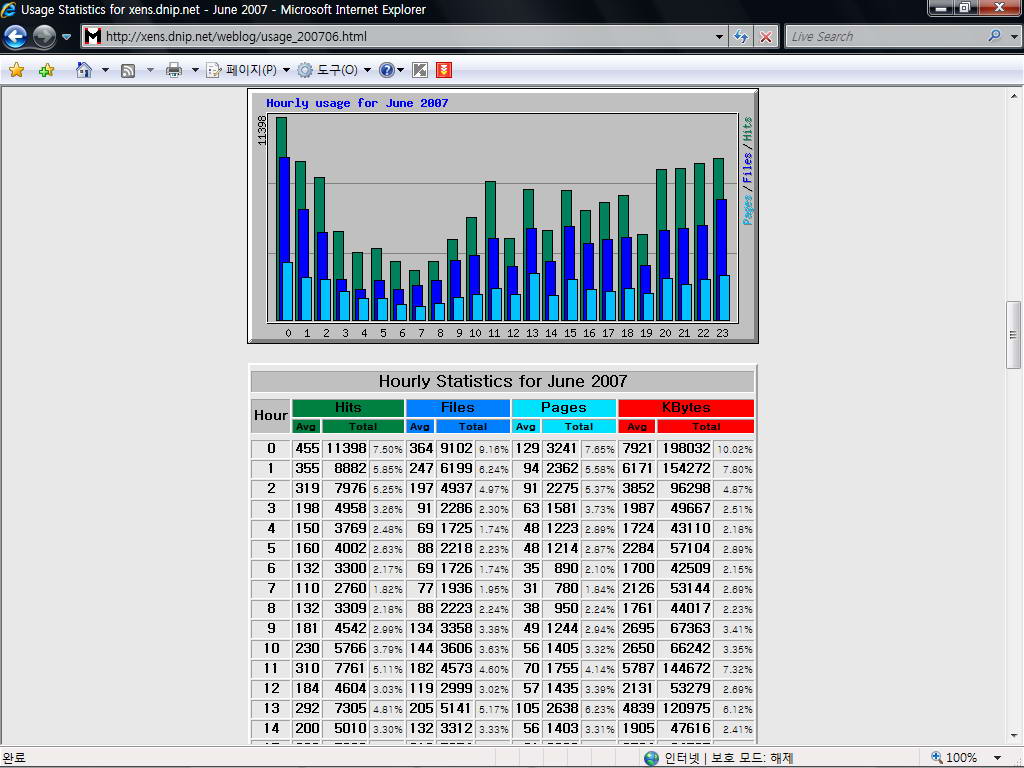

시간별로 어느시간대에 접속이 가장많은지 적은지 쉽게 알아볼수 있는 통계도 있다. 여기서 보면

23~24시에 Hits수가 가장 많고 아침 7시에 가장 적은것을 볼 수 있다. Kbytes 통계로 어느시간대에

다운로드량이 가장 많은지도 알수있다.

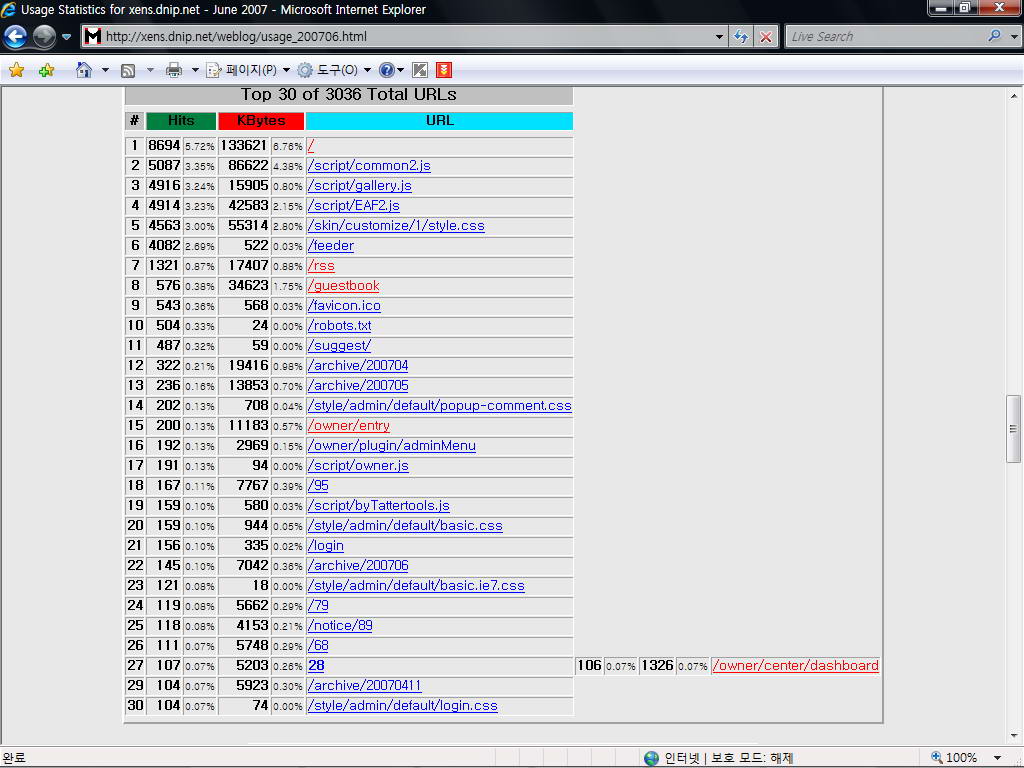

주고 있다. 이는 어떤 페이지를 가장 많이 보았는지를 의미하는데 어느블로그던 개인홈페이지던

비슷하겠지만 root 디렉토리가 0순위이다. 이를 통해 블로그에서나 어떤 홈페이지에서 어떤 페이

지가 방문자들이 읽는 횟수가 많은지 판단해서 그와 관련된 내용을 더 많이 올려 방문자수를 높히는

전략(?)을 세울수도 있겠다.

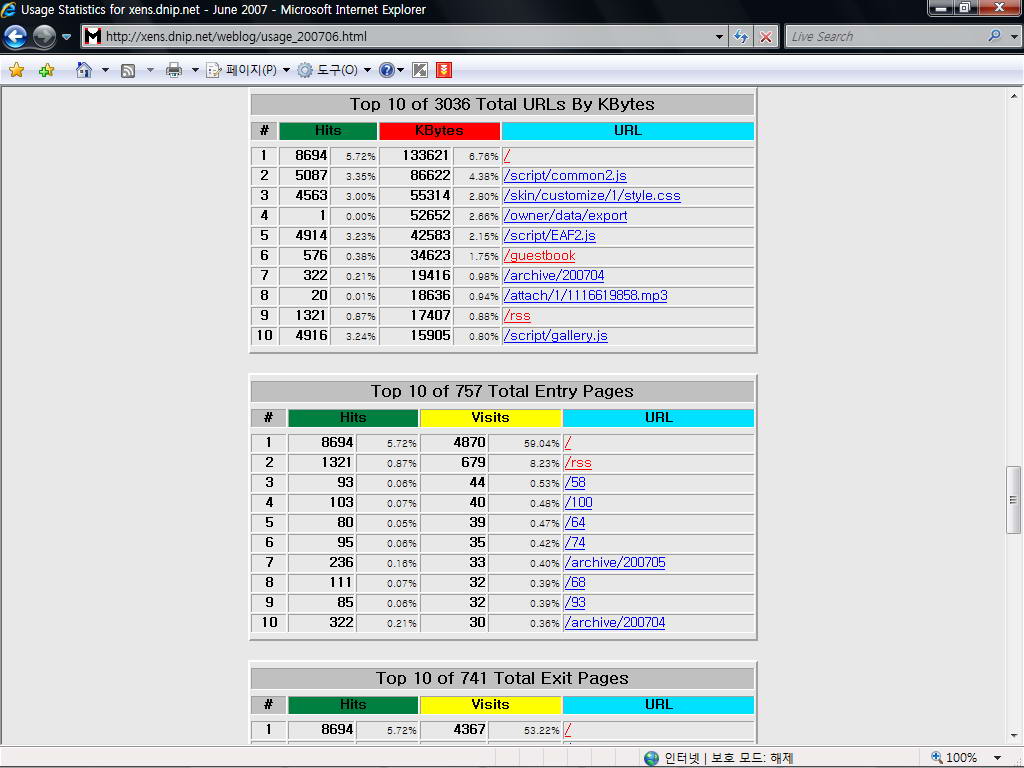

Top 10 of ?? Total URLs by Kbytes : 데이터 전송량을 기준, 방문객들이 본 웹페이지중 가장

방문이 많은 상위 10개의 파일들을 보여준다. 여기서 보면 물론 root가 가장 많다. 그외 root를 읽어

들일때 따라서 읽히는 파일들 또한 전송량이 많다. 그외에는 그다지 전송량이 크지 않은것을 볼 수

있다.

Top 10 of ?? Total Entry Pages : 방문자가 처음으로 접속한 페이지의 랭킹을 상위 10위권으로 표시해준다. 여기서 보면 물론 root가 가장 많을것이고 다음은 rss피드 페이지가 많다. 물론 이것

으로도 어떤 페이지를 방문객들이 와서 많이 읽는지 대략 알 수 있다.

Top 10 of ?? Total Exit Pages : 방문자가 마지막으로 보고 나간 페이지의 상위 10위권 통계이다. 이것으로 어느 페이지가 방문객들에게 가장 인기가 없었는지 대략 알 수 있다. 하지만 이것만으로 섣불리 판단하기엔 부족하다. 필요한 정보만 다른 검색엔진에서 찾아서 보고 나갈수도 있기때문이다. 여기서 보면 root의 경우 Entry pages와 Exit pages가 동일한데 블로그 표시설정시 내가 한

페이지씩만 보여주도록 설정해놨기 때문인지 직접 내블로그 주소로 들어왔을때 방문객들이 다른 글을 읽는일이 아주 많지는 않다는것을 알수있다.

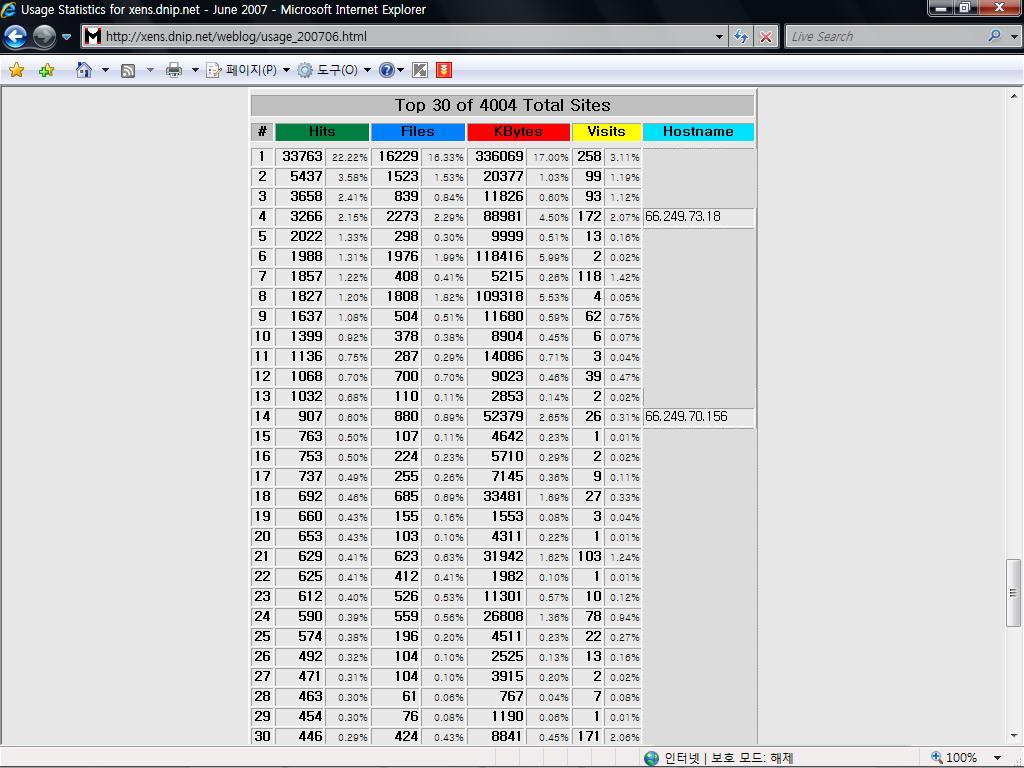

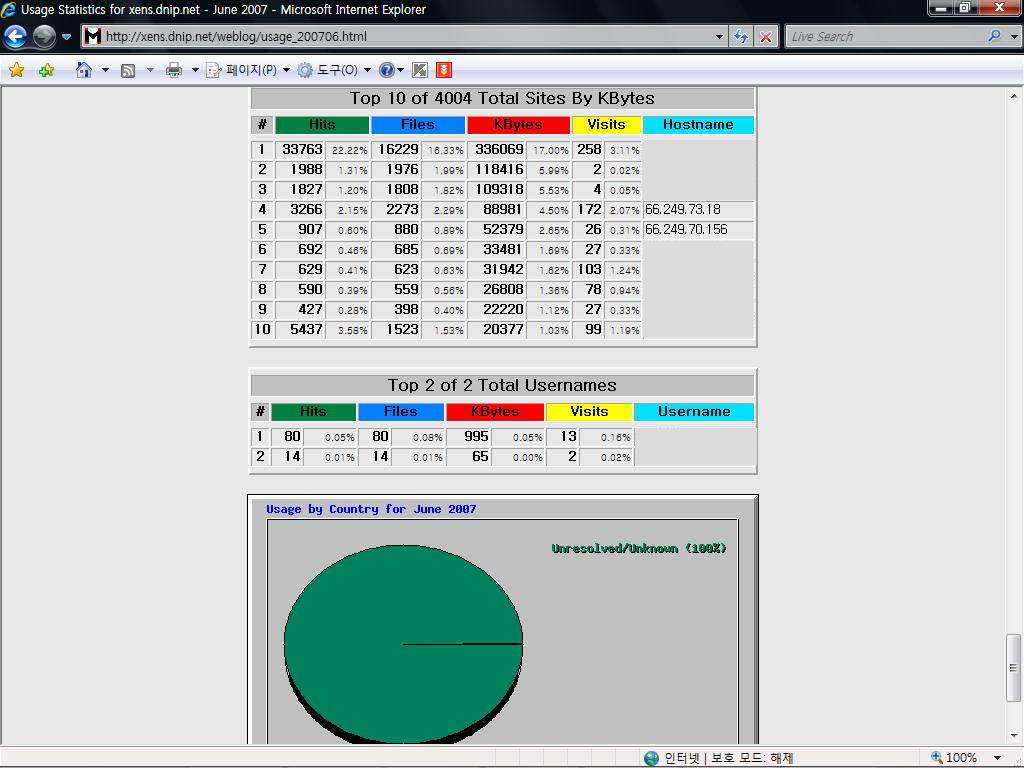

Hits수를 기준으로 어느곳에서 접속이 많이 이뤄졌는지 상위 30위권으로 표시된다. IP로 표시가

되는데 저두개의 IP는 구글 로봇이다. 첫번째는 내가 접속한 것인데 아무래도 글올리고 하다보면

내가 가장 접속이 많은건 당연하지 않을까 싶다. 구글 로봇이 얼마나 많이 접속하는지는 위에서

보면 알수있다. 내가 258번 접속하는데 구글 로봇이 두개만 합쳐도 198번이나 된다. 이것이 내가

호스팅 업체를 쓰지 않고 직접 서버를 돌려 블로그를 운영하는 이유중에 하나이다. 물론 검색엔진

에 자신의 블로그가 노출되는것은 좋은일이지만 다른파일도 봇들이 무차별로 순식간에 긁어가면서

트래픽을 크게 유발시키는 경우가 많다. robots.txt 파일에서 검색엔진 봇들이 한시간에 한번만

접속하게 해뒀는데도 많은 접속률을 보이고 있다.

전송량에 따른 상위 10위권의 순위를 보여준다. 이것도 IP로 표시되며 위에서 몇개의 IP들은 삭제해

놨지만 위의 두개의 봇들은 구글로봇들이다. 나머지 몇개의 IP들도 봇들이고 전송량이 꽤 된다.

그 아래는 Usernames에 따른 전송량,Hit수,방문수등을 보여준다. 그아래는 국가별 접속한 통계를

보여주는데 설정해놓은것이 없어서 한가지만 100%로 나온다. 윈도우용 Webalizer를 기본적으로

별다른 설정없이 설치했을때는 여기까지의 내용을 기본적으로 알아볼수가 있다. 물론 조작을

거쳐 레퍼러순위통계를 볼수도 있고 검색어 통계를 볼수도 있고 에이전트별(브라우저나 OS종류)

통계를 볼수도 있고 국가별 접속 통계를 볼수도 있다.

'웹서버관련정보 > 윈도우' 카테고리의 다른 글

| [팁] phpmyadmin에 로컬에서만 접속가능하게 하는법 (0) | 2007.11.12 |

|---|---|

| [강좌] 아파치 2.0.x , 2.2.x 설정가이드 (0) | 2007.08.26 |

| [팁] PHP 5.1.x 버전에서 5.2.x 버전으로 업그레이드 하기 (0) | 2007.06.20 |

| [팁] PHP업그레이드후 Nmail 사용문제 해결방법 (0) | 2007.06.20 |

| [팁] Zend Optimizer 업그레이드 하기 (2) | 2007.06.20 |