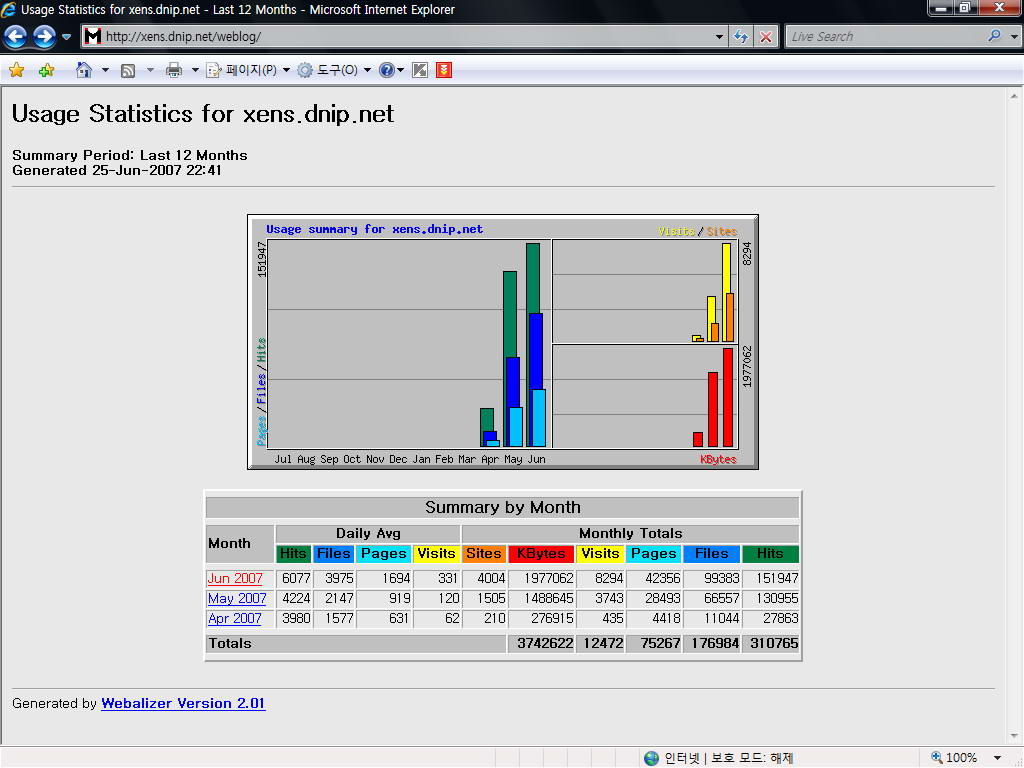

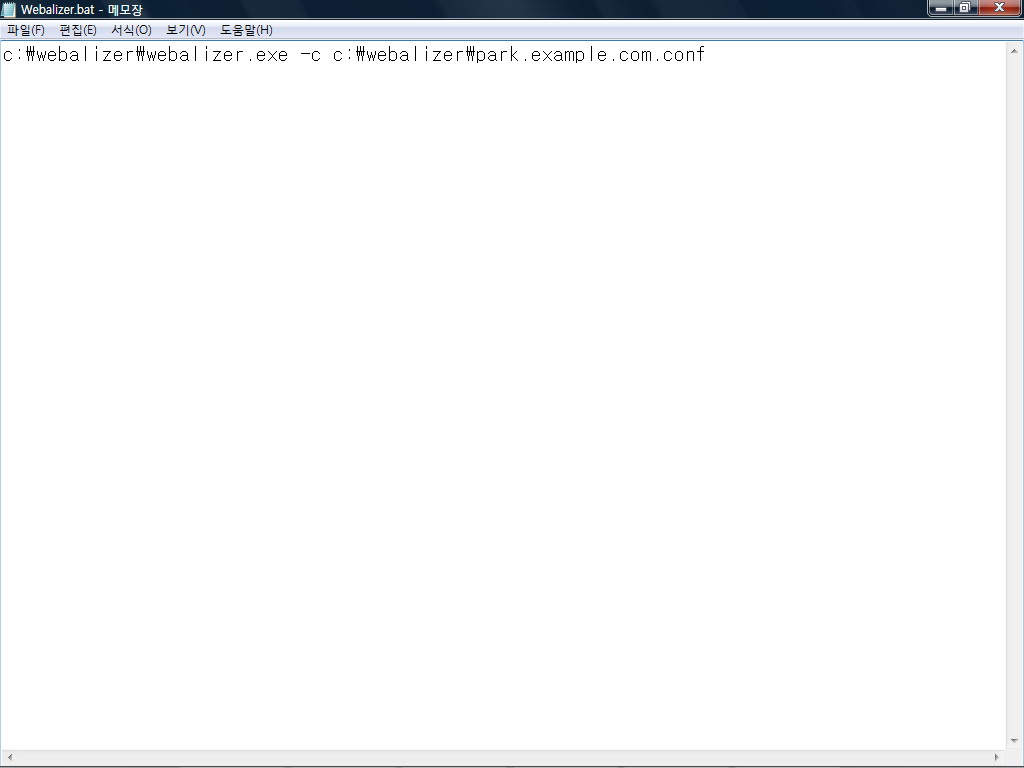

Webalizer는 아파치 서버의 로그를 자세한 통계로 보여주는 서버관리자에게는 상당히 유용한 툴이다. 물론 Webalizer 말고 다른 로그분석툴이 많지만 일단 Webalizer가 가장많이 쓰이고 윈도우용으로 Cygwin으로 컴파일되어서 제공되기 때문에 설치도 비교적 간단한 편이다. (설치방법은 http://xens.dnip.net/54 참고) 설치만 해놓고 그냥 보기만 해서는 잘이해가 되지 않을것이다. 그래서 내 블로그의 6월분 로그내용을 가지고 분석하는 방법을 알아보겠다. 웹얼라이저를 실행하면 다음과 같이 접속 통계를 일단 간단히 볼수 있다. 항목별로 자세히 보자. Hits : 서버로부터 요구된 파일들의 합계이다. 클라이언트들이 만약 그림 3개를 요구했다면 해당 웹페이지까지 합해 4개의 Hits가 ..